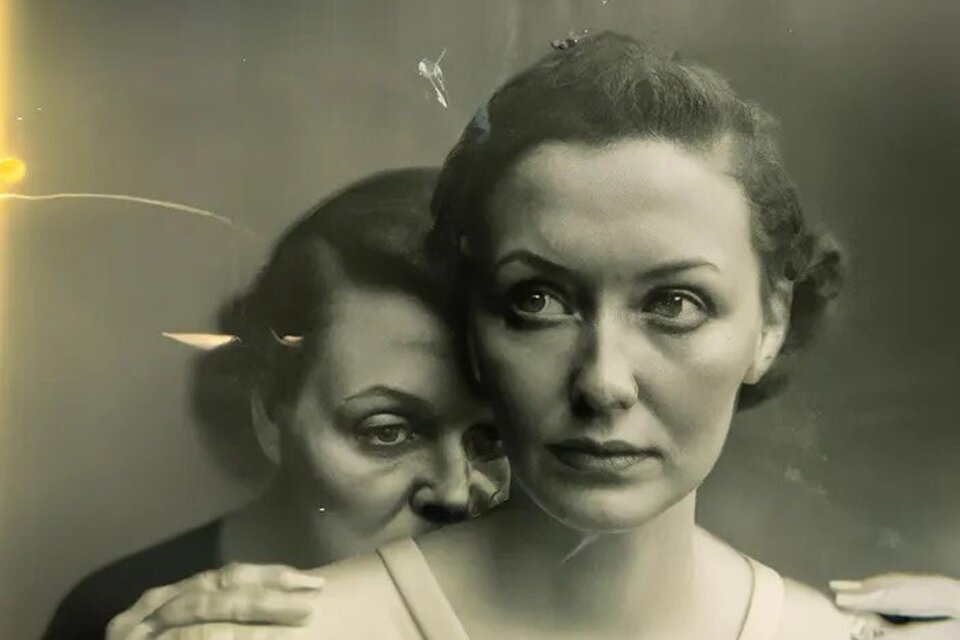

Hace unos días el fotógrafo alemán Boris Eldagsen presentó, intencionalmente, una imagen que conquistó al jurado de la prestigiosa “Sony World Photography Awards”. Se trataba de dos mujeres posando, cerca una de la otra, en color sepia.

Esa fotografía, que ganó la categoría Creatividad, se había hecho con Inteligencia Artificial (IA), y nadie pudo percatarse de aquello.

Tampoco pudieron prevenir el éxito que sería la primera canción realizada completamente por una IA, con las voces de Drake y The Weeknd. El tema "Heart on My Sleeve" se hizo viral en Tik Tok y llevó hasta al gigante discográfico, Universal Music Group, a tomar acciones por el uso indebido y faltas a los derechos de autor.

Constanza Richards Yáñez, profesora en la facultad de Derecho en la Usach y que este año impartió clases de un Máster sobre Inteligencia Artificial y Gobierno Corporativo en la Facultad de Economía y Negocios de la Brunel University London, Gran Bretaña, plantea que los conflictos jurídicos van a empezar a aparecer durante este año con una “frecuencia impresionante”.

“Algunos de los riesgos ético-jurídicos, y que han sido resaltados por varios científicos hace un par de semanas, tienen que ver con este aspecto, con la intromisión en la intimidad de las personas a través del uso de esta tecnología”, aseguró la académica.

Para Marcela Jamett Domínguez, académica del Departamento de Ingeniera Eléctrica, es vital que se tomen los tiempos necesarios para estudiar y analizar con calma el avance de la IA.

“La medida específica, de ponerle esta pausa, creo que es importante. No es la única solución, principalmente porque es necesario estudiar y analizar con calma, porque los humanos no somos tan rápidos como las máquinas, hay que ver las posibles regulaciones que tengan que incluir”, planteó Jamett.

Algo en lo que está de acuerdo Geoffrey Hinton, conocido como el “padrino” de la IA, que dejó Google para hablar de los peligros de esta tecnología. El experto teme que internet se inunde de falsos textos, fotos y videos, con herramientas como ChatGPT o Midjourney, pero también que las nuevas herramientas reemplacen a muchos trabajadores.

“Es difícil ver cómo se puede evitar que los malos actores lo usen para cosas malas”, manifestó esta semana el pionero de la IA al New York Times. En su opinión, se deberían frenar los avances en dicho ámbito hasta que se entienda bien si será posible controlar la IA.

Una opinión parecida tiene Marcela Jamett, quien asegura que son necesarias leyes, tal como se hizo cuando comenzó el boom del internet y se estableció la ley del ciberdelito.

“Se van a tener que hacer estas leyes, la IA llegó para quedarse, hoy en día sí somos monos con navaja, estamos jugando con algo que podría ser potencialmente peligroso, tanto a nivel de perjudicar a una persona con calumnias o al nivel de poder darle herramientas para una empresa para sustituir a toda su gente por robot, sin tener que incurrir en ese costo social. Si yo tengo una empresa puedo sustituir con una IA, lo puedo hacer, pero ese costo social tiene que ser retribuido a la sociedad para que no quede la embarrada”.

Constanza Richards diría que la IA se viene trabajando desde hace mucho antes. Personalmente, la académica comenzó a estudiarla en 2018, aunque gracias a la masividad que alcanzó a fines del 2022, y con mayor fuerza este 2023, ahora es un tema que se toca con mayor profundidad.

“Hoy la masividad y el avance de la tecnología ya lo vemos en la vida diaria. Es más masivo. Quizás en menos tiempo se podrían perder trabajos, no quiero ser alarmista, las tecnologías pueden reemplazar actividad, pero para eso se necesitan recursos, no sé si es muy caro, pero tampoco es tan barato y simple. Hay trabajos que se pueden hacer, pero creo que podría haber una reconversión de trabajo”, indicó la académica.

¿De quién es la culpa?

La profesora en la facultad de Derecho en la Usach, Constanza Richards Yáñez, sabe que uno de los temas más preocupantes es que la gente sepa distinguir la realidad a la hora de utilizar estar herramientas de IA, pero también ver qué sesgos pueden tener.

“El chat GPT es de una base de datos, donde toma toda la información que tiene disponible y ensambla de acuerdo a ciertos patrones y algoritmos, que le resultan coherentes. Por eso es que no distingue la “realidad”. Ahí puede haber sesgos, no solo mentira de verdad, discriminación, riqueza, pobreza. Por ejemplo, las mujeres siempre hacen esto, no significa que la IA tenga sesgo o el programador, no significa que el algoritmo sea discriminador, lo que no significa que no existan protocolos para eso. Hay responsabilidad jurídica sí, pero no una culpabilidad moral o penal”, planteó.

Sobre los problemas que puede tener la IA en el corto plazo, la académica Constanza Richards manifestó que las confusiones filosóficas, éticas o jurídicas pueden ocurrir a la hora de trabajar con una programación interna.

“Por ejemplo, el que la máquina, por ejemplo, el misil teledirigido que va buscando un objetivo y que ajusta su punto hasta dar con ese objetivo, con la tecnología para situaciones de guerra, este misil no está pensando por sí mismo. No esta razonando, y no está conociendo fines de su actuar, sino que son instrucciones previamente programadas por un ser humano o por el fabricante. Y en ese sentido, esa distinción es fundamental, y me agradó ver que los ingenieros informáticos tienen muy claro que la responsabilidad es siempre del diseñador y del programador. Por muy compleja que sea la actividad de la IA, las instrucciones del comportamiento y cómo los sesgos y decisiones, tienen su raíz, su origen y su causa en el diseño, por lo tanto la responsabilidad es del diseñador o en conjunto del dueño del aparato que ofrece el servicio autónomo”.

Para Marcela Jamett Domínguez, académica del Departamento de Ingeniera Eléctrica, otro punto importante al que hay que tener cuidado es que la IA se puede mal utilizar, ya sea para difamar o para no asumir culpabilidad por un cierto hecho.

“El peligro va en asociar responsabilidad, una persona real que difama a otra puede ser demandado y pagar lo que tenga que pagar, esa discusión ética se ha hecho hace tiempo atrás cuando hubo este boom de los autos autónomos, que se manejaban solos. "¿Qué pasaba si atropellaban a alguien?", quién tiene la culpa, el dueño del auto, la marca, porque finalmente eso es muy complicado y en el caso de este señor que fue difamado por este chat que dijo que abusaba efectivamente no hay responsables. Dado estos vacíos hay un riesgo ahí que se haga mal uso, por ejemplo difamar a alguien, tomar noticias falsas, incluso en el aspecto académico incurrir en plagios, y no poder verificar la información”, afirmó.

Otro tema que preocupa es el posible reemplazo de trabajadores, pero la académica Jamett no cree que en el corto plazo se reemplacen trabajos. “Hay algunas tendencias que creen que esto, la IA, va a sustituir muchos trabajos, va a sustituir a los investigadores, hasta médicos, pero la verdad es que eso más que ser una realidad inminente dejaría todo el conocimiento de la humanidad como estancado y se echaría a perder. Me explico, si el ser humano ha logrado avanzar en su desarrollo del conocimiento y los avances de distintos tipos es gracias a la capacidad creativa que este tipo de IA solo obtiene de lo ya creado. Puede llenar huecos, vacíos con información, pero sin tener detrás una lógica, una moral, un pensamiento crítico, sin poder identificar lo verdadero de lo falso. O sospechar de algo falso. Ahí están las barreras que se pueden mejorar”.

Por último, la académica aseguró que la llegada de la Inteligencia Artificial puede ser un plus para una mayor libertad para el ser humano. “Ha habido avance de la historia que la tecnología nos ha apoyado para tener más tiempo libre, derechos humanos, por ejemplo evitar un trabajo peligroso o sumamente denigrante, uno puede, gracias a estas tecnologías, tener una mejor calidad de vida”, concluyó.

Leer también

Bioquímica, astrofísica e ingeniería matemática: Mujeres científicas destacan en...

Jueves 23 de enero de 2025

“Mi deseo final es que mi cuerpo se done a la ciencia”: Qué pasos se realizan y...

Jueves 17 de octubre de 2024

Los sonidos del estallido social: El rol que jugó la música tras el 18-O

Miércoles 16 de octubre de 2024